- 科技報導

- 精選好讀

文章專區

2024-04-15人工智慧有可能產生自我意識嗎? 《身為自己》

508 期

Author 作者

阿尼爾.塞斯

在加蘭的電影《人造意識》中,隱居的億萬富翁科技天才內森,邀請程式高手迦勒來到偏遠的隱祕地點,看看他所創造的,聰明又好奇的機器人艾娃。迦勒的任務是判斷艾娃是否有意識,或者她(它)只是一個智慧機器人,根本沒有內在的生命。

《人造意識》的劇情大量運用了圖靈測試,這是評估機器是否能夠思考的著名標準。在一個尖銳的場景中,內森向迦勒詢問測試的情況。正如迦勒所瞭解的,圖靈測試的標準版本是一個人類評審只透過交換打字訊息,遠端與候選機器和另一個人類對話。當評審無法區分人類和機器時,該機器便通過測試。但內森心裡想的更有趣,例如在談到艾娃時,他說「這項挑戰在於已先告訴你她是一個機器人,再看你是否仍覺得她具有意識」。這種新玩法把圖靈測試從智力測試轉變為「意識測試」,正如我們現在所知,兩者是非常不同的情況。更重要的是,導演加蘭呈現給我們的是:這根本不是關於機器人的測試。正如內森在劇中所說,重要的並非艾娃是否為機器,甚至也不是艾娃是否是一部有意識的機器。最重要的是艾娃是否能讓一個有意識的人感覺到她(或它)是有意識的。內森和迦勒交談的精彩之處,在於它揭示了這種測試的真正含義:這是對人類的測試,而不是對機器的測試。不論對於圖靈的原始測試,或對加蘭在二十一世紀意識導向的等效測試來說,情況都是如此。加蘭所寫的對白,優雅地捕捉到將意識賦予機器的困難點,以致「加蘭測試」一詞在今日越來越受到關注——這是科幻電影逆向影響科學的罕見例子。

現在有很多簡單的電腦程式,包括各種聊天機器人,都宣稱「通過」了圖靈測試,因為有相當比例的人類評審在足夠比例的時間內被騙過了。在一個特別奇怪的例子中,三十個人類評審中有十人被誤導,認為一個假裝成十三歲烏克蘭男孩的聊天機器人,是真正的十三歲烏克蘭男孩。這些例子導致許多人認為「在人工智慧領域裡長期存在的里程碑終於被超越了」的喧囂聲不斷。當然,冒充英語不好的外國青少年,比冒充與自己年齡、語言和文化相同的人要容易得多,尤其是在只允許遠端文字交流的情況下。當聊天機器人獲勝時,它的回答是「我感覺已經用相當簡單的方式擊敗圖靈測試」。一旦我們把標準降低到如此程度,測試就變得容易通過。這等於是對人類輕信程度的考驗,而人類失敗了。

隨著人工智慧的不斷改進,電腦可能很快就不需要人為地降低標準,便能通過圖靈測試。二○二二年五月,OpenAI研究實驗室發布了GPT-3——一個使用來自網際網路的大量自然語言範例,進行訓練的龐大人工神經網路。除了進行聊天機器人式的對話外,GPT-3還可以在給定少量初始詞語或句子時,生成多種不同風格的大段文字。雖然它並不明白自己生成的內容,但GPT-3輸出的流暢性和複雜度令人驚訝,對某些人來說甚至令人恐懼。在《衛報》上發表的一個例子中,它寫了一篇長達五百字的文章,講述人類為什麼不該害怕人工智慧—內容涵蓋從人類暴力心理學到工業革命等,其中包括令人不安的一句話:「人工智慧不該浪費時間去嘗試理解那些不信任人工智慧者的觀點。」

儘管GPT-3非常複雜精細,但我非常確定它可以被任何一個夠老練的人類對話者給揭穿。雖然對於以後的GPT-4或甚至一直到GPT-10來說,這點可能不會成立。但即使未來類似GPT-3的系統可以多次通過圖靈測試,它也只會表現出一種非常狹隘的(模擬)智慧——一種非實體的語言交流,而非完全體現「在正確的時間做正確的事」,亦即我們在人類和許多其他動物中,以及我假設的矽野獸機器中會看到的自然智慧。

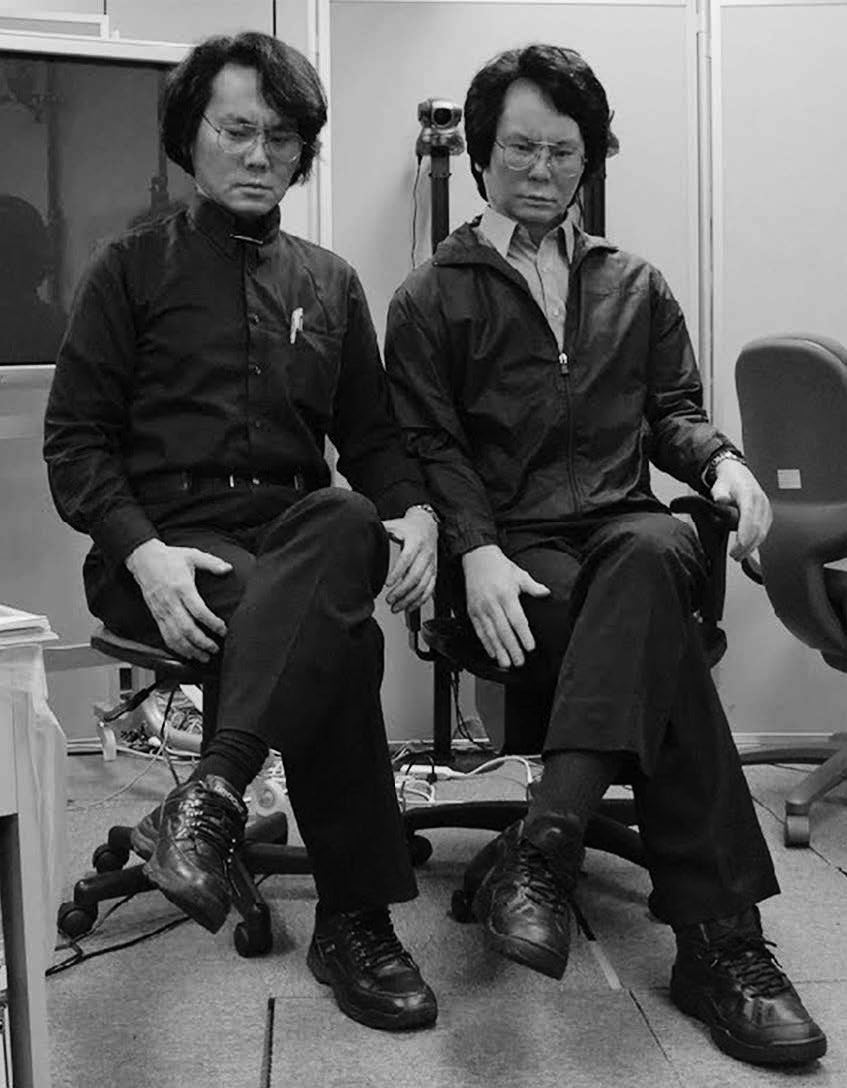

就意識而言,並沒有烏克蘭聊天機器人程度等價的意識能力,更別說GPT-3程度的意識能力了。加蘭測試仍能保持原先的地位。事實上,創造有感知能力的「人類仿真擬像」嘗試,常常會令人產生焦慮和反感,而不是像《人造意識》中迦勒對艾娃所產生的那種吸引、同情和憐憫等複雜的混合情感。日本機器人學家石黑浩(Hiroshi Ishiguro),花了幾十年的時間建造與人類盡可能相似的機器人。他稱它們為仿真機器人(Geminoids)。石黑浩創造了他自己(見左圖)和他女兒(當時六歲)的機器人複製版本,以及大約基於三十個不同人類所混合的日歐電視女主播仿真機器人。這些仿真機器人均由詳細的3D身體掃描建構而成,並配有能夠生成各種面部表情和手勢的氣動執行器。這些設備裡幾乎沒有人工智慧,因為它們都是關於人類的模仿。比較可能的應用則包括「遠端呈現」等,例如石黑浩曾經使用他的仿真機器人,為大學生進行了四十五分鐘的遠端課程。

石黑浩與他的仿真機器人。(ATR Hiroshi Ishiguro 實驗室圖片提供)

仿真機器人無疑地令人毛骨悚然。它們很逼真,但又不夠逼真。請想像一下遇到像人的仿真機器人,以及遇到完全不像人類的貓。對於貓(章魚也可以)來說,即使外觀如此不同,也會立即感受到另一個有意識的實體的存在。然而仿真機器人那引人注目但不完美的實體相似性,只會加強脫離現實以及差異的感受。在二○○九年的一項研究中,訪問仿真機器人的參觀者,最常感到的情緒便是「恐懼」。

這種情緒反應就是所謂的「恐怖谷」(uncanny valley) 效應,這個概念是由另一位日本研究者森政弘(Masahiro Mori)於一九七○年提出的。森政弘指出,當機器人開始看起來像人類時,會引起人們越來越積極和移情的反應(如《星際大戰》中的C-3PO)。然而,一旦過了某個點,亦即在某些方面看起來非常像人,但在其他方面又沒那麼像時(太像卻又不是的情況),這些反應就會迅速轉變為厭惡和恐懼,也就是所謂的「恐怖谷」。只有當相似性變得更加接近、難以區分的時候,這種厭惡反應才會消失。關於恐怖谷為何存在有許多理論,但毫無疑問它確實存在。

儘管現實世界的機器人很難逃離恐怖谷效應,但在虛擬世界的發展已經開始翻山越嶺,走到另一個境界。在機器學習的最新進展方面,使用「生成式對抗神經網路」(簡稱GANN),可以生成從未實際存在過的人類的逼真面孔(見下頁圖)。這些圖像利用巧妙混合來自實際面孔的大型數據庫特徵而創建,採用類似於我們在幻覺機器中所使用的技術(在第六章描述過)。當與「深偽」(deepfake)技術相結合時,便可將這些面孔動畫化,讓他們說出任何語言。如果他們所說的內容也由日益複雜的語音識別和語言生成軟件(如GPT-3)提供支援時,我們就會像是突然生活在一個充滿虛擬人物的世界裡,這些虛擬人物在虛擬世界(如影片)的實際表現上,與真實人物幾乎難以區分。於是在這樣的世界裡,我們將習慣於無法分清誰真誰假。

八個面孔。這些都不是真實存在的人。

任何認為這些最新發展在通過「針對影片強化的圖靈測試」之前便會遇上阻礙的人,其想法可能是錯的。會以這種方式思考的人,要不是抗拒人類例外論的頑固範例,要不就是缺乏想像力,或者兩者兼有之,因為它真的會通過測試。不過,目前還有兩個問題,首先是這些新的虛擬創作是否能穿越到現實世界——例如可以從石黑浩的擬真機器人仍被困住的恐怖谷中逃離。

第二個問題是加蘭測試是否也會失效?我們是否會覺得這些新的代理實體真的具有意識,而且真的具有智慧—即使你知道它們只不過是幾行程式代碼?如果我們確實有這種感覺,對我們會產生什麼影響?

———

人工智慧的迅速崛起——無論它是由何種炒作和與現實所混合推動——都已經引發一場復興且必要的倫理討論。許多道德關切都與近期技術(如自駕汽車和自動化工廠工人等)的經濟和社會影響有關,難以避免地會帶來許多重大干擾。

人們對於將決策能力委託給人工系統存在著合理的擔憂,其內部運作可能很容易受到各種偏見和反覆無常的影響,而且對受影響者以及設計它們的人來說,這些內部運作都不夠透明。在極端情況下,例如若人工智慧系統負責核武或網際網路基礎骨幹的話,到底會引發什麼恐怖後果呢?

而對人工智慧和機器學習的心理和行為後果,也存在著道德方面的擔憂。深偽技術的隱私侵犯、預測性演算法的行為修正,以及社群媒體中的過濾氣泡(filter bubbles,網站針對用戶事先過濾訊息)和迴 室(echo chambers,俗稱同溫層效應)中的信念扭曲,都只是影響社會結構的眾多力量之一。藉由這些力量的釋放,我們心甘情願地將自己的身分和自主權,交給不露面的數據公司進行一場巨大且難以控制的全球性實驗。

在這種背景下,關於機器意識的道德討論,可能會顯得既放縱任性又深奧難懂,不過事實並非如此。即使目前相關的機器沒有(尚未擁有)意識,這些討論也是必要的。當加蘭測試通過時,我們便可以與被認為擁有主觀內心生活的實體分享我們的生活,即使我們可能知道或相信它們其實並未擁有意識。我們很難預見這點在心理上或行為上的後果。其中一個可能性就是,我們將學會區分我們的「感受」以及我們該如何「行動」。如此一來,儘管我們覺得兩者都有意識,但去關心人類而非關心機器人就會顯得很自然。目前尚不清楚這會對我們的個人心理產生什麼影響。

在電視劇《西方極樂園》(Westworld)中,仿真機器人是專門為虐待、殺害和強姦而開發的—亦即作為人類最邪惡行為的發洩對象。人類是否可能感覺到機器人有意識的同時,又清楚知道它其實並沒有意識,因而在虐待機器人時不會讓自己的心智崩潰?因為以一般現代人的正常心智而言,這樣的虐待行為是高度的反社會行為。另一種可能性是我們的道德關注範圍,將因為我們以「人類為中心」的傾向而扭曲,亦即我們將對那些感覺更相似的實體產生更多同理心;在這種情況下,我們可能會更關心新一代仿真機器人(作為你的雙胞胎),而不是關心其他人,更非關心其他動物了。

當然,並非所有的未來場景都必須如此「反烏托邦」。但隨著人工智慧的進步和炒作之間的競爭加劇,基於心理學的道德規範也必須發揮作用。我們不能只是推出新科技,然後等著看會發生什麼事。更重要的是,我們不該盲目追求重建並超越人類智慧的人工智慧標準。正如丹尼特明確指出的,我們正在構建「智慧工具而非工作夥伴」,我們必須確實清楚其間的差異。

最後就是面對真正的機器意識的可能性。如果我們有意或無意地將新形式的主觀體驗引入世界,我們便將面臨前所未有的倫理和道德危機。一旦某個東西具有意識狀態,它也就具有道德地位。我們將有義務盡量減少其潛在的痛苦,就像我們有義務盡量減少其他生物的痛苦一樣,然而我們在這方面的表現並不好。對於這些被假設為具有人工感知的實體,我們還會面臨另一項挑戰,那就是我們可能不知道它們正在經歷什麼樣的意識。請想像當一個系統遭受一種全新形式的痛苦折磨時,人類對此並沒有相應的等價物或概念,也沒有任何可以識別它的本能。請再想像一個對於積極情緒和消極情緒的區別無法加以判斷的系統,當然也就沒有相應的現象層面可供判別。這裡的道德挑戰就是:我們甚至不知道相關的道德問題是什麼?

2REY0019%e8%ba%ab%e7%82%ba%e8%87%aa%e5%b7%b1-%e7%ab%8b%e9%ab%94(%e6%9b%b8%e8%85%b0)300dpi.jpg)

書 名|身為自己:人類意識的新科學

作 者|阿尼爾.塞斯(Anil Seth)

譯 者|甘錫安、吳國慶

出版社|鷹出版

出版日期|2024年1月

「身為自己」是什麼意思?我們的「內在小宇宙」是如何形成的?

世界頂尖意識腦科學專家塞斯(Seth):我們對世界和對自己的認知,全都是一種「受控的幻覺」

無論你是不是科學家,意識都是很重要的奧祕。對每個人而言,我們的意識經驗就是眼前的一切。沒有意識,就什麼都沒有,沒有世界、沒有自己、沒有內在也沒有外在。

而意識的奧祕最吸引人的面向,就是自我的本質。我是誰?為什麼我以第一人稱的方式體驗生活?過往我們一直以為有一個所謂的「自己」,外在於我們肉體身軀的靈魂,他感受著的一切,經歷著一切,並查看著一切,做出選擇與判斷。

然而,現在的意識腦科學研究告訴我們,「身為自己」並不像聽起來那麼簡單。